AIと有事:差別への適切な対応

AIを知りたい

先生、『有事への対応』って、AIが差別的な結果を出してしまったときのことですよね?どう対応するのが正解なんでしょうか?

AIエンジニア

そうだね。AIが差別的な結果を出してしまった場合の対応だね。正解というのは難しいけれど、重要なのは、問題が起きた時にサービスを止めるか続けるかよりも、なぜそのような問題が起きたのかを丁寧に説明することだよ。

AIを知りたい

でも、サービスを止めるのと続けるのでは、対応が違うように思うのですが…

AIエンジニア

確かに、サービスを停止する方が大きな問題として捉えられているように見えるかもしれないね。しかし、どちらの場合でも、まずはなぜそうなったのかを解明し、きちんと説明する責任があるんだよ。そして、再発防止策をしっかり示すことが大切なんだ。

有事への対応とは。

人工知能を使う際に、どうしてもデータのかたよりが生じてしまい、その結果、差別につながるような人工知能ができてしまう危険性があります。これまでの例を見ると、問題が起きたとき、すぐにサービスを止めて、謝罪と説明をする場合と、批判に反論する場合がありました。人工知能のサービスを続けるか止めるかに関わらず、なぜそうなったのかをきちんと説明することが大切です。

はじめに

人工知能(じんこうちのう)は、今や私たちの暮らしの様々なところに深く入り込んでいます。便利な道具として、なくてはならないものになりつつありますが、その使い方によっては、思わぬ落とし穴にはまる危険性も持っています。人工知能は、大量のデータから物事を学ぶため、もしもそのデータに偏りがあると、差別や偏見につながる結果を生み出してしまうことがあるのです。これは、人工知能を作る人たちだけでなく、使う人たち、そして社会全体にとって、真剣に取り組むべき課題と言えるでしょう。

例えば、ある企業が採用活動に人工知能を導入したとします。過去の採用データに基づいて学習した人工知能が、特定の属性を持つ人々を不利に評価してしまうかもしれません。あるいは、ローン審査に人工知能が使われた場合、過去のデータに含まれる社会的な不平等を反映して、ある特定の集団に対して不公平な審査結果を出してしまう可能性も考えられます。このようなことが起きた場合、私たちはどのように対応すべきでしょうか。

過去に起きた様々な事例を参考にしながら、適切な対応策を考えていく必要があります。まず、人工知能がどのように学習し、どのような結果を生み出すのかを透明化することが重要です。人工知能の判断過程を明らかにすることで、問題の原因を特定しやすくなります。次に、データの偏りをなくすための工夫が必要です。多様なデータを用いたり、偏りを修正する技術を導入することで、公平な結果が得られるように努めなければなりません。さらに、人工知能が出した結果を常に人間が確認し、必要に応じて修正する仕組みも必要です。人工知能はあくまでも道具であり、最終的な判断は人間が行うべきです。

人工知能は、正しく使えば私たちの社会をより良くする力を持っています。しかし、潜在的なリスクを理解し、適切な対策を講じることが不可欠です。私たちは、人工知能とどのように付き合っていくべきか、常に考え続け、より良い未来を築いていく必要があるでしょう。

| 人工知能の課題 | 具体的な例 | 対応策 |

|---|---|---|

| データの偏りによる差別や偏見 | 採用活動、ローン審査などでの不公平な評価 |

|

過去の事例に見る対応

人工知能による差別問題は、その対応の仕方によって、結果が大きく異なる事例がいくつも存在します。大きく分けて二つのパターンがあり、一つは問題が明らかになった後、速やかにサービスの提供を停止し、お詫びと原因の説明を行うというものです。例えば、ある会社の開発した人工知能が特定の人種に対して不適切な言葉を表示したという事例では、会社は直ちにサービスを停止し、公式な場で謝罪を行いました。さらに、どのような仕組みで差別的な表現が生じたのかを詳細に説明し、再発防止のための対策を発表しました。このような迅速で誠実な対応は、利用者からの信頼を回復することに繋がりました。

もう一つのパターンは、批判の声に対して反論したり、問題自体を軽く見たりするという対応です。別の会社の事例では、人工知能が女性に対して差別的な判断を下しているという指摘に対し、会社側は当初、問題を認めず、批判の声を無視しました。しかし、批判が大きくなるにつれ、対応を迫られ、最終的には謝罪することになりました。しかし、最初の対応が不適切だったため、会社の評判は大きく傷つきました。

これらの事例から、人工知能による差別問題が発生した場合、問題を隠蔽したり、軽視したりすることは決して得策ではないことが分かります。問題が明らかになった時点で、速やかに対応することが重要です。具体的には、サービスの停止、公式な謝罪、原因の説明、そして再発防止策の実施が不可欠です。また、問題の原因究明には、社外の専門家などを交えた第三者委員会などを設置し、客観的な視点を取り入れることも重要です。人工知能は常に発展を続けている技術であり、差別的な要素を完全に排除することは難しいかもしれません。だからこそ、問題が発生した場合の対応こそが、企業の信頼性を左右すると言えるでしょう。

| 対応パターン | 事例 | 結果 |

|---|---|---|

| 迅速な対応 | 特定の人種に不適切な言葉を表示したAI、サービス停止、謝罪、原因説明、再発防止策を発表 | 利用者からの信頼回復 |

| 問題の軽視/反論 | 女性への差別的判断を下すAI、当初問題を認めず批判を無視、最終的に謝罪 | 会社の評判悪化 |

説明責任の重要性

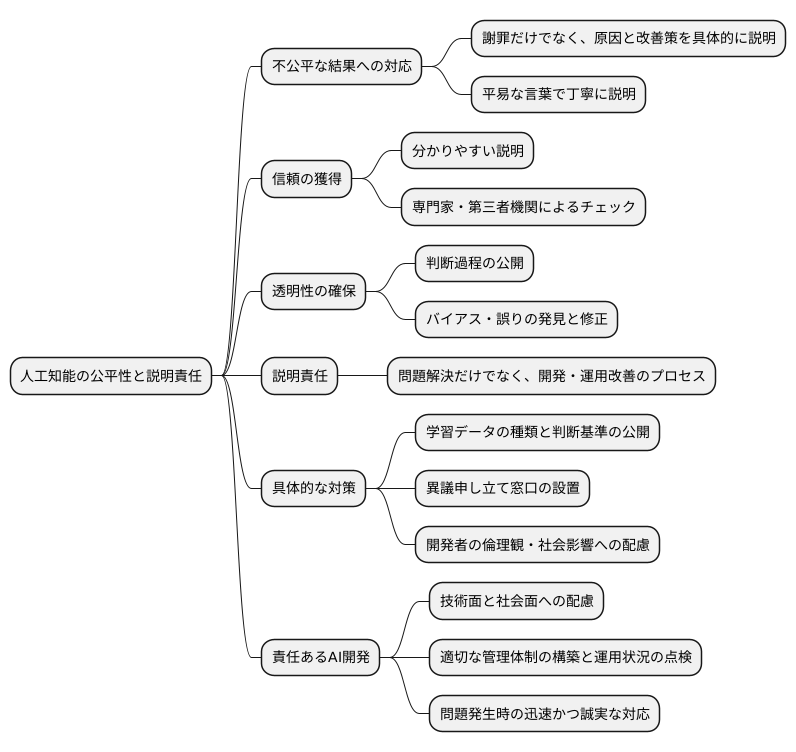

人工知能が不公平な結果を導き出したとき、企業はその責任を明らかにすることが求められます。これは、ただ申し訳ないと言うだけではなく、どうしてそのような結果になったのか、これからどのような方法で改善していくのかを具体的に示すことを意味します。人工知能の仕組みは複雑で、一般の人には理解しづらい部分も少なくありません。だからこそ、誰もが分かる平易な言葉で丁寧に説明することが大切です。

分かりやすい説明は、使う人の理解と信頼を得るために欠かせません。また、専門家や第三者機関によるチェックも、公正さを保証するために有効な手段となります。人工知能がどのように判断を下したのかを明らかにすることで、バイアス(偏り)や誤りがあればそれを発見し、修正することができます。この透明性の確保こそが、人工知能の信頼性を高める鍵となります。説明責任を果たすことは、単に問題が発生したときの後始末をするだけでなく、人工知能の開発や運用をより良いものにするための大切なプロセスとも言えます。

具体的には、人工知能が学習した情報の種類や、判断の基準を公開することが考えられます。また、人工知能が出した結果に対して、異議を申し立てる窓口を設けることも重要です。さらに、人工知能の開発に携わる人たちが、倫理的な観点や社会への影響について深く考える必要があります。責任ある人工知能開発のためには、技術的な側面だけでなく、社会的な側面にも目を向けることが重要です。企業は、人工知能による差別や不公平を防ぐための適切な管理体制を構築し、その運用状況を定期的に点検する必要があります。そして、問題が発生した場合には、迅速かつ誠実な対応をすることが求められます。このような努力を通してこそ、人工知能は人々の生活をより豊かにする力となるでしょう。

再発防止への取り組み

一度起きた差別的な出来事は、企業の信用を大きく傷つけ、社会全体にも大きな影響を与えます。そのため、二度と同じことが起きないよう、徹底した対策が必要です。

まず、差別を招く原因の一つとして、学習データの偏りがあります。もし特定の集団に関する情報ばかりが学習データに含まれていると、そこから作られるAIも偏った判断をしてしまう可能性があります。ですから、多様なデータを集め、偏りをなくすことが大切です。

次に、AIの判断の仕組みである計算手順、つまり算法の改善も重要です。算法に問題があれば、たとえデータが公平であっても差別的な結果を生み出す可能性があります。そのため、算法を常に確認し、改善していく必要があります。

さらに、AIが正しく動いているかを常に監視する仕組みも必要です。たとえ開発段階で問題がなくても、運用中に新たな問題が発生する可能性もあります。そのため、監視体制を構築し、問題があればすぐに対応できるようにする必要があります。

また、倫理的な考え方に基づいたAI開発の指針を作り、開発者への教育を徹底することも欠かせません。技術的な対策だけでなく、開発に携わる人々が倫理的な意識を持つことが、差別を防ぐ上で重要です。AI技術は日々進歩しており、新しい問題も出てくる可能性があります。そのため、常に学び続け、改善を重ね、倫理的な側面を意識した開発を続けることが大切です。

| 対策 | 詳細 |

|---|---|

| 学習データの偏りへの対策 | 多様なデータを集め、学習データの偏りをなくす |

| 算法の改善 | 算法を常に確認し、改善していく |

| AIの監視 | 監視体制を構築し、問題があればすぐに対応できるようにする |

| 倫理教育の徹底 | 倫理的な考え方に基づいたAI開発の指針を作り、開発者への教育を徹底する |

社会全体の協力

人工知能の倫理に沿った使い方は、ある特定の会社だけが考える問題ではなく、社会全体で協力して取り組むべき重要な課題です。人工知能が社会にもたらす影響は大きく、その使い方を誤れば、大きな損害を生む可能性も否定できません。だからこそ、皆で協力して、安全な使い方を考えていく必要があるのです。

まず、国や研究機関、市民団体などが協力して、人工知能に関する倫理的な指針を作る必要があります。この指針は、人工知能を開発・利用する際の道しるべとなるものです。どのような人工知能を作るべきか、作ってはいけないのか、作った人工知能をどのように使うべきか、使ってはいけないのか、といったことを明確に示す必要があります。

次に、作った指針を広く人々に知ってもらうための活動も必要です。人工知能はまだ新しい技術であり、その倫理的な側面について理解している人は多くありません。講演会や資料配布などを通して、多くの人に人工知能の倫理について考えてもらう機会を設ける必要があります。

さらに、人工知能によって不公平な扱いを受けないか監視する仕組みを作ることも重要です。人工知能は大量の情報を処理し、そこから判断を行うため、意図せず特定の人々を不公平に扱う可能性があります。このような事態を防ぐため、人工知能の判断過程を監視し、問題があればすぐに対応できる体制を整える必要があります。

人工知能の技術は、私たちの暮らしをより豊かにする大きな可能性を秘めています。しかし、その可能性を最大限に引き出すためには、倫理的な問題に真剣に取り組み、社会全体でよく話し合うことが欠かせません。人工知能とどのように付き合っていくべきか、未来を見据えて、共に考えていきましょう。

| 項目 | 説明 |

|---|---|

| 倫理指針の作成 | 国、研究機関、市民団体などが協力し、AI開発・利用の道しるべとなる倫理指針を作成。AIの開発/不開発、使用/不使用の基準を明確化。 |

| 指針の普及啓発 | 講演会や資料配布などを通して、AI倫理に関する理解促進のための活動を実施。 |

| 監視体制の構築 | AIによる不公平な扱いを防ぐため、判断過程を監視し、問題発生時の対応体制を整備。 |

まとめ

人工知能(じんこうちのう)は、私たちの暮らしを便利にする様々な可能性を秘めています。例えば、家事の手伝いや、病気の診断、新しい薬の開発など、多くの分野で活躍が期待されています。しかし、それと同時に、人工知能を使うことで、意図せず差別が生じてしまう可能性も懸念されています。

人工知能は、大量のデータから規則性やパターンを学び、判断や予測を行います。もし、学習に使うデータに偏りがあった場合、人工知能は偏った判断をするようになってしまいます。例えば、過去の採用データに男性が多い場合、人工知能は男性を採用する方が良いと判断するかもしれません。これは女性にとって不公平であり、差別につながる可能性があります。

もし人工知能が差別的な結果を生み出した場合、企業は責任を持って対応する必要があります。まず、なぜそのような結果になったのかを詳しく調べ、原因を特定しなければなりません。そして、問題を解決するために必要な対策を迅速に実施し、社会に説明する必要があります。具体的には、学習データの偏りを修正したり、人工知能の判断基準を見直したりする必要があるでしょう。

人工知能を正しく使うためには、社会全体で協力していくことが大切です。人工知能を作る企業だけでなく、使う人、そして人工知能について研究する人も、それぞれの立場で倫理的な問題について考え、話し合う必要があります。人工知能の技術は日々進歩しています。だからこそ、私たちは人工知能とどのように付き合っていくべきか、常に考え続け、責任ある行動を取ることが重要です。より良い社会を作るために、人工知能を正しく理解し、上手に活用していく必要があるでしょう。人工知能の進歩と倫理的な課題について、共に学び、考えていくことで、明るい未来を築けると信じています。

| 人工知能のメリット | 人工知能のデメリット | 差別への対策 | 私たちへの課題 |

|---|---|---|---|

| 家事の手伝い、病気の診断、新薬の開発など、様々な分野で活躍が期待されている。 | 学習データに偏りがある場合、偏った判断をしてしまい、差別につながる可能性がある。 |

|

|