ResNet:層を深くする技術

AIを知りたい

先生、『ResNet』ってどういうものですか?なんか、残りの何とかって聞いたんですけど、よく分からなくて。

AIエンジニア

『ResNet』(レズネット)は、画像認識などで使われるAIのモデルの一つだよ。残りの何とかというのは、『残差ブロック』のことだね。積み木を積み重ねるように、たくさんの層を積み重ねて作られているんだ。そして、この残差ブロックがResNetの大事な特徴なんだ。

AIを知りたい

残差ブロック…ですか?どんなものなんですか?

AIエンジニア

簡単に言うと、近道を作るようなものだよ。普通の積み木は上にどんどん積み重ねていくだけだけど、ResNetでは途中の層を飛び越えて、先の層に直接繋がる近道を作るんだ。これを『スキップコネクション』と言う。このおかげで、より深く積み重ねることができ、画像認識の精度が向上したんだよ。

ResNetとは。

人工知能の用語で「ResNet(レズネット)」というものがあります。これは、画像認識などで使われる技術です。ResNetは、「残差ブロック」と呼ばれるものをいくつも繋げて作られています。この残差ブロックは、畳み込み層という部分と、近道を作る「スキップコネクション」という部分を組み合わせたものです。このスキップコネクションのおかげで、層を深く重ねることが可能になり、結果として認識精度が向上しました。

残差学習とは

残差学習は、深い構造を持つ学習機械の学習をより円滑にするための、画期的な手法です。深い構造を持つ学習機械は、層が浅いものよりも多くの情報を表現できる可能性を秘めていますが、実際には層を深くすると、情報の変化が小さくなりすぎたり、逆に大きくなりすぎたりする問題が生じ、学習がうまく進まないことが知られています。残差学習は、まさにこれらの問題に対処するために開発されました。

通常の学習機械では、入力された情報から出力される情報への直接的な対応関係を学習しようとします。しかし、残差学習では、入力情報と出力情報の差、つまりどれだけ変化したかを学習します。この差こそが「残差」です。残差を学習することで、層が深くても、情報の変化が適切に伝わり、学習が安定します。

残差学習の仕組みを直感的に理解するために、各層が入力情報に少しだけ手を加える様子を想像してみてください。それぞれの層は、入力された情報を大きく変えるのではなく、微調整を加える役割を担います。そして、この微調整を幾重にも繰り返すことで、最終的には複雑な情報表現を獲得できるのです。これは、まるで職人が丁寧に細工を施し、素材に新たな価値を吹き込む工程にも似ています。

層が深くなることで生じる問題は、学習の妨げとなる大きな壁でしたが、残差学習はこの壁を乗り越えるための、まさに橋のような役割を果たしています。この革新的な手法によって、より深く、より複雑な学習機械の構築が可能となり、様々な分野で応用が進んでいます。

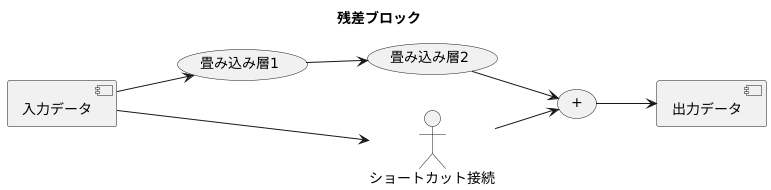

残差ブロックの仕組み

深層学習において、層を深く重ねるほど学習が難しくなる勾配消失や勾配爆発といった問題が存在します。この問題を解消するために考案されたのが残差学習であり、その中心的な役割を担うのが残差ブロックです。残差ブロックは、幾つかの畳み込み層とショートカット接続と呼ばれる経路を組み合わせた構造を持っています。

畳み込み層は、画像認識で重要な役割を果たす層で、入力データから様々な特徴を抽出する働きをします。フィルターと呼ばれる小さな窓をスライドさせながら入力データの特徴を捉え、次の層へと情報を渡します。複数の畳み込み層を積み重ねることで、より複雑で抽象的な特徴を抽出することが可能になります。

一方、ショートカット接続は、入力データをそのまま出力データに加算する経路です。畳み込み層を通らずに情報が伝わるため、まるで高速道路のジャンクションのように、入力データがスムーズに出力へと流れていきます。このショートカット接続こそが残差学習の肝であり、恒等写像(入力と出力が同じであるような変換)の働きをすることで、層が深くなっても学習が阻害されにくくなるのです。

具体的には、畳み込み層で抽出された特徴と、ショートカット接続を経由した入力データが合流して出力データが生成されます。これにより、ネットワークは、畳み込み層で学習した新たな特徴に加えて、入力データそのものの情報も保持することができます。この仕組みにより、深いネットワークであっても勾配が消失しにくくなり、安定した学習が可能となります。残差ブロックは、まるで高速道路網のように情報を効率的に流し、深層学習モデルの性能向上に大きく貢献しているのです。

ResNetの構造

残差ネットワーク(ResNet)は、画像認識などの分野で優れた成果を上げている深層学習モデルです。その名の通り、残差ブロックと呼ばれる特別な構造を積み重ねて構成されています。まるで高層ビルのように、各階が一つの残差ブロックに相当し、それらを積み重ねることで複雑な情報を処理できるようになります。

ResNetには、ResNet-18、ResNet-34、ResNet-50、ResNet-101、ResNet-152など、様々な種類があります。これらの数字は、ネットワークの層の数を表しています。例えば、ResNet-18は18層、ResNet-152は152層から成り立っています。一般的に、層の数が多いほど、ネットワークはより複雑な表現を学習できます。しかし、層数を増やすだけでは、必ずしも性能が向上するとは限りません。深いネットワークでは、勾配消失問題といった学習を阻害する問題が発生しやすいためです。

ResNetの重要な特徴は、この勾配消失問題を解消するために導入された「スキップ接続」です。スキップ接続とは、入力データを幾つかの層を飛び越えて出力側へ直接加算する経路のことです。これにより、深い層にも勾配が伝わりやすくなり、学習が安定します。各残差ブロックには、このスキップ接続が含まれています。スキップ接続を導入することで、従来の深層学習モデルでは困難だった非常に深いネットワークの学習が可能になりました。

ResNetは、画像認識だけでなく、物体検出や画像の領域分割など、様々なコンピュータビジョンタスクで高い性能を示しています。その革新的な構造は、深層学習の発展に大きく貢献し、多くの後続のモデルに影響を与えました。ResNetの登場は、深層学習における大きな転換点と言えるでしょう。まるで建築技術の進歩によって、より高いビルが建てられるようになったように、ResNetのスキップ接続は、より深いネットワークの実現を可能にし、深層学習の可能性を広げました。

| 項目 | 説明 |

|---|---|

| ResNetとは | 画像認識などの分野で優れた成果を上げている深層学習モデル。残差ブロックと呼ばれる構造を積み重ねて構成。 |

| 種類 | ResNet-18, ResNet-34, ResNet-50, ResNet-101, ResNet-152など。数字は層の数を表す。 |

| 層の数 | 層が多いほど複雑な表現を学習できるが、勾配消失問題が発生しやすくなる。 |

| スキップ接続 | 勾配消失問題を解消するために導入。入力データを幾つかの層を飛び越えて出力側へ直接加算する経路。深い層にも勾配が伝わりやすくなり、学習が安定。 |

| 応用分野 | 画像認識、物体検出、画像の領域分割など、様々なコンピュータビジョンタスク。 |

| 貢献 | 深層学習の発展に大きく貢献し、多くの後続のモデルに影響。 |

ResNetの利点

残差ネットワーク、略してResNetは、画像認識などの分野で画期的な成果を上げた深層学習モデルです。その最大の強みは、非常に深いネットワーク構造を学習できる点にあります。ネットワークの層が深くなるほど、より複雑な特徴を捉えることができ、識別能力が向上します。しかし、従来の深層学習モデルでは、層を深くすると、勾配消失問題と呼ばれる現象が発生し、学習がうまく進まないことがありました。ResNetはこの問題を残差学習という革新的な手法で解決しました。

残差学習とは、各層で入力信号をそのまま出力に伝える経路(ショートカット接続)を設ける方法です。これにより、層が深くなっても勾配が消失しにくくなり、安定した学習が可能となります。まるで、迂回路を用意することで、情報の流れをスムーズにするような仕組みです。この残差学習によって、ResNetは100層を超える非常に深いネットワークを構築し、従来のモデルを凌駕する高い性能を達成しました。

また、ResNetは計算効率の良さも大きな利点です。残差ブロックと呼ばれる構成単位は、シンプルな構造をしているため、計算量を抑えつつ高い性能を実現できます。処理速度が重要な応用分野では、この効率性の高さが大きなメリットとなります。限られた資源で最大限の効果を発揮する、まさに無駄のない設計と言えるでしょう。

これらの利点から、ResNetは画像認識だけでなく、物体検出やセグメンテーションなど、様々なタスクで広く活用されています。深層学習の発展に大きく貢献したResNetは、今後も様々な分野で応用が期待される、重要な技術です。

| 項目 | 説明 |

|---|---|

| 名称 | ResNet (残差ネットワーク) |

| 強み | 非常に深いネットワーク構造を学習できる |

| キーテクノロジー | 残差学習 (ショートカット接続による勾配消失問題の解決) |

| 利点 |

|

| 応用分野 | 画像認識, 物体検出, セグメンテーションなど |

ResNetの影響

残差ネットワーク、略してResNetの登場は、深層学習の世界に大変革をもたらしました。それ以前、深い層を持つニューラルネットワークの学習は、勾配消失問題と呼ばれる壁に阻まれていました。層が深くなるにつれて、学習に必要な情報が薄れてしまい、うまく学習が進まないのです。ResNetはこの問題に、「残差接続」という画期的な仕組みで解決策をました。

残差接続とは、層の出力を次の層にそのまま渡すのではなく、幾つかの層をスキップして、出力に元の入力を加える構造です。まるで近道を作るように、学習に必要な情報の流れをスムーズにすることで、勾配消失問題を回避し、非常に深いネットワークの学習を可能にしたのです。ResNet以前は、層を深くすると性能が低下する現象が見られましたが、ResNetによって100層、1000層といった超深層ネットワークが実現可能となり、画像認識をはじめとする様々なタスクで精度の飛躍的な向上を達成しました。

ResNetの成功は、残差学習という考え方を深層学習の標準的な技術として確立しました。今では、画像認識だけでなく、自然言語処理や音声認識など、様々な分野の深層学習モデルで残差接続が利用されています。ResNetのアーキテクチャもまた、その後の深層学習モデル設計に大きな影響を与え、様々な派生モデルが誕生しました。ResNetは単なる一つのモデルではなく、深層学習研究の羅針盤となり、その後の発展に重要な方向性を示したと言えるでしょう。深層学習は日進月歩で進化しており、ResNetを礎とした更なる革新、更なる発展に大きな期待が寄せられています。ResNetの登場は、深層学習の歴史における重要な道標として、今後もその輝きを失うことはないでしょう。

ResNetの課題と将来

残差ネットワーク(ResNet)は画像認識の分野に革新をもたらした画期的な技術です。層を深く積み重ねることで、より複雑な特徴を捉えることができるようになりました。しかし、ResNetにはいくつかの課題も存在します。

まず、ResNetは計算コストが比較的高いことが挙げられます。多くの層と多数のパラメータを持つResNetは、大量の計算を必要とします。そのため、処理能力の低い携帯端末や組み込み機器などでは、ResNetの利用が難しい場合があります。限られた計算資源の中で効率的に動作するResNetの改良版が求められています。

次に、ResNetの構造が複雑であることも課題の一つです。多数の層と複雑な接続を持つResNetは、最適な設定を見つけるのが困難です。学習率や正則化の強さなど、様々な設定項目を調整する必要がありますが、最適な値を見つけるには多くの試行錯誤が必要となります。このため、ResNetの利用には専門的な知識と経験が求められます。より簡単に最適な設定を見つける手法の開発が期待されています。

さらに、ResNetの説明可能性の低さも課題として挙げられます。ResNetがどのように判断を行っているのかを理解することは難しいです。これは、ResNetが複雑な構造を持つこと、そして、学習過程で自動的に調整されるパラメータの数が膨大であることに起因します。判断の根拠を理解できないことは、ResNetの信頼性を低下させる要因となります。判断過程を可視化したり、説明可能な構造を開発するなどの研究が重要です。

これらの課題はResNetの更なる発展を阻む可能性がありますが、同時に今後の研究の重要な方向性を示しています。計算コストの削減、構造の簡略化、説明可能性の向上など、様々な研究が進められています。これらの研究成果がResNetの進化を促し、画像認識だけでなく、自然言語処理や音声認識など、様々な分野でResNetが活用される未来が期待されます。ResNetはまるで成長過程にある樹木の様に、更なる進化を続け、深層学習の可能性を広げていくことでしょう。

| 課題 | 詳細 | 求められる解決策 |

|---|---|---|

| 計算コストが高い | 多くの層とパラメータによる大量の計算が必要。携帯端末や組み込み機器での利用が困難。 | 限られた計算資源で効率的に動作する改良版の開発 |

| 構造が複雑 | 多数の層と複雑な接続のため、最適な設定を見つけるのが困難。専門知識と経験が必要。 | 簡単に最適な設定を見つける手法の開発 |

| 説明可能性が低い | 判断過程の理解が困難。複雑な構造と膨大なパラメータが原因。信頼性低下に繋がる。 | 判断過程の可視化、説明可能な構造の開発 |